Seit 50 Jahren mach ich offiziell in Digitalisierung. Unter anderem habe ich da viele Hypes erlebt.

In diesem Beitrag schreibe ich über die Hypes, an die ich mich erinnere. Aber nicht als wissenschaftliche Arbeit sondern mehr zum Schmunzeln.

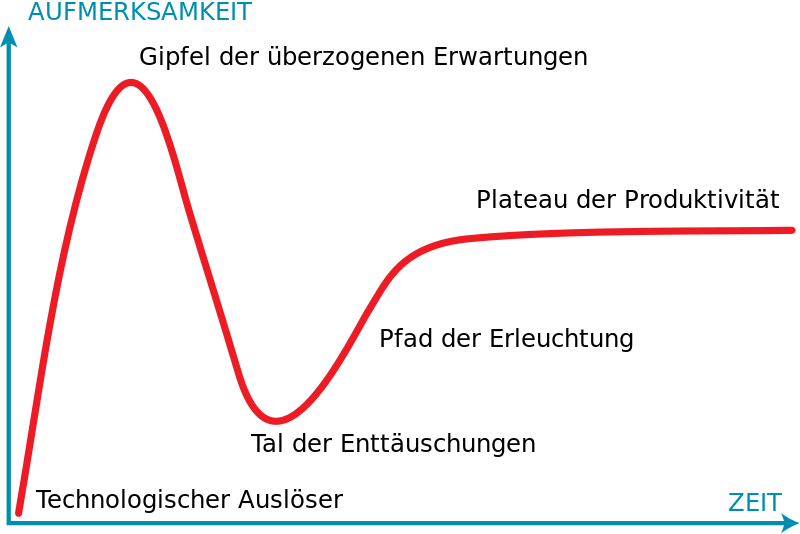

Lasst mich berichten. Zuerst, was ist ein Hype?

Ganz einfach:

Es gibt einen Auslöser. Der kann völlig unterschiedlich sein wie ein technischer Durchbruch, ein singuläres Ereignis, eine Massenhysterie …

Dann geht der Goldrausch los. Und gar nicht selten gibt es ein bitteres Ende.

Oft gilt:

Nichts gewesen ausser Spesen.

Als KPI’s für Hypes kann man nehmen:

- die Anzahl von Neugründungen von Unternehmen zum Hype-Thema,

- die Höhe des im Umfeld des Hypes investierten Investment-Kapitals

- die Anzahl der Vorträgen, die Politiker, Analysten und andere Klugschwätzer über das Thema halten (meistens ohne davon etwas zu verstehen)

- und weitere (man muss nur ein wenig nachdenken, dann fällt einem vieles ein).

Zurzeit reden alle über Digitalisierung. Die ist so ein Mega-Hype, die viele Unter-Hypes enthält.

Hypes in der Digitalisierung

In den den 70iger Jahren habe ich beim Siemens in „industrieller Informatik“ (so wie ich das nenne) gemacht. Das war eher so richtiges Ingenieurs-Schwarzbrot. Wir haben klassich programmiert. Zum Beispiel Betriebssysteme, Module für Datenfernverarbeitung und Rechnernetze, Datenbanken und Transaktionsmonitore.

Alles nicht so aufregend. Und auch ziemlich „hype-frei“. Parallel kamen Hypes wie kleine bunte Computer, die Spiele konnten. Das war schon aufregender.

KI

Den ersten Hype, den ich zu Beginn sehr bewußt erlebt habe, war der KI-Hype. Jeder, der sich für modern hielt, machte ein wenig auf Künstliche Intelligenz (KI). Und wer ganz modern sein wollte, sprach von „Artificiel Intelligenz“ (AI). Für mich in der Industrie-Informatik war das Thema unerreichbar.

Ein Zauberwort war damals „Expertensystem“. Besonders beliebt war das in Bereichen wie der Medizin. Die Tagungen zu KI/AI waren voll mit digitalen Träumern.

Neben den Expertensystemen gab auch schöne Exoten – so haben Freunde von mir an einem System gebastelt, dass aus dem Geräusch eines Hubschraubers heraushören sollte, ob alles noch stimmen würde. Korrekt müsste ich schreiben, sie haben das versucht – das Projekt ist nie Realität geworden. Auch so ein Hype-Schicksal.

Damals spalteten zwei Programmiersprachen die KI/AI-Community. Für die einen war Lisp die einzig wahre Sprache für KI/AI, für die anderen Prolog.

Bei Prolog war mir schnell klar, dass die Hardware für das aufwändige Back-Tracking noch nicht leistungsfähig genug war. Trotzdem wurde gerade in Japan viel mit Prolog gemacht. Meistens waren das akademische Projekte – und meines Wissens ist da nie viel rausgekommen. Eine Hobby-Variante gab es auch. Die hieß Turbo-Prolog (so wie Turbo-Pascal). Ein Unternehmen der InterFace war damals die „InterFace Computer GmbH“. Die hatten das wahrscheinlich beste Prolog der Welt. Und die Entwicklung von IF-Prolog hat das Unternehmen ruiniert. Von Lisp habe ich bis heute keine Ahnung.

Eine Definition, was künstliche Intelligenz von normaler, auch als algorithmisch bezeichneter Software unterscheidet, gab es nicht. Heute haben wir ja wieder einen KI/AI-Hype. Und wenn ich dann einen der „Speaker“ frage, wie der künstlich Intelligenz definieren würde, kommt selten eine vernünftige Antwort. Weiter unten werde ich meine Definition zu besten geben – aber ob die viel mehr taugt weiss ich auch nicht.

Ich habe in meinem Leben viele Hypes erlebt. Größere wie Kleinere. Soviele, dass ich sie mir gar nicht merken konnte. Ich nenne mal ein paar Hypes, die ich so erlebt hatte (und an die ich mich noch erinnere).

Ganz früh waren es mal die Hybrid-Rechner. Die Synergie von Analog und Digital sollte neue Dimensionen eröffnen. Dieser Hype war vorbei, bevor er los ging. Dann erinnere ich mich an Ontologie, die gefördert wurden wie kein Informatik-Thema zuvor. Risc-Prozessoren sollten Server schneller machen. Die objektorientierte Programmierung war ein Hype und hatte ein paar kleine Kinder wie „objekt-orientierte“ Datenbanken. Manches davon ist verschwunden, anderes zum Standard geworden.

Irgendwann mal ging alles um die Farbe im Büro. Natürlich ist das heute alles selbstverständlich, aber meine HIT/CLOU-Kunden aus der Finanzindustrie haben sich schon sehr stark endlich mal die Farbe „ROT“ gewünscht (für die roten Zahlen in den Bilanzen …)

Der Wunsch nach Farbe hat auch den Client-Server-Hype befördert, der auf bunten Windows-PCs beruhte und der nach meiner Meinung kräftig vom Wunsch der Menschen profitierte, Solitär zu spielen zu können. Die „Organizer“ waren hype, bis sie das Smart Phone als Kombination von Organizer und Mobil-Telefon ablöste. Und auf all diesen Geräten kann man ja auch Solitär spielen.

Dann hatten wir den Hype der „rich clients“ (eigentlich ist heute ein jedes Smartphone ein „rich client“).

Parallel dazu kam das Internet. Und später dass WWW2. Das waren dann gleich 2 Hypes auf einmal. Der Unterschied war, dass irgendwelche Menschen bemerkt hatten, dass es im Internet nicht nur Konsumenten gibt. Das war aber von Anfang an so, denn ohne Anbieter gibt es nichts zu lesen.

Seit zwanzig Jahren bin ich regelmäßig in der Jury von BayStartUp (das Unternehmen, das in Bayern die Business-Plan-Wettbewerbe organisiert) und mittlerweile weitere Angebote für Menschen hat, die ein Unternehmen gründen wollen. Da sehe ich, welche Hypes gerade „IN“ sind. Hier ein paar Stichproben.

Es gab Zeiten, da wollten die meisten Jung-Unternehmer Geschäftsmodelle rund um APPs und später PORTALE entwickeln.

Zwei Jahre lang ging es vor allem um 3D-Drucker. Zwischendurch waren es dann auch 3D-Brillen und die zugehörige Infrastruktur …

(Wobei der 3D-Drucker ein gutes Beispiel ist, wie Patente Entwicklung behindern und die Technologie sich erst durchsetzt, wenn das Patent abgelaufen ist).

Betreffend 3D-Brille, da bei uns lag schon vor Jahren so eine unter dem Weihnachtsbaum. Ich fand den möglichen Content damals ziemlich schwach – und viel besser ist es wohl nicht geworden.

Irgendwann mal war die Blockchain der Renner. Die dürfte eine Spitzenstellung als Hype einnehmen – besonders wenn man die Höhe des spekulativ verbrannten Geldes mit in die KPI aufnimmt.

Ein gar nicht so sehr wahrgenommener Hype dürfte aktuell der Einsatz von Sensoren sein. Immerhin tragen diese dazu bei, dass wir bald nicht mehr von einer Mensch-Maschine-Schnittstelle sondern von einer Welt-Maschine-Kommunikation reden werden. Der Mensch ist dann nur noch ein Teil der Welt ist (hoffentlich kein störender).

Viele Mit-Hyper warnen schon vor der Diktatur der Maschinen. Die aber auch nicht schädlicher sein dürfte als die aus Menschen bestehenden Regierungen.

Heute ist es klar:

Der Hype heißt wieder KI/AI. Kombiniert mit „big data“. So werden wir vor einer schrecklichen Welt gewarnt – und lähmen die „Digitalisierung“ mit Datenschutz. So rauben wir uns viele gesellschaftliche Chancen. Und vergessen, dass KI/AI und Bigdata nur technischer Fortschritt sind. Und dieser hat schon immer die Gesellschaft verändert. Meistens zu unserer Erleichterung.

Natürlich war es immer wichtig, mit dem technischen Fortschritt verantwortungsvoll um zugehen. Das ist der Menschheit nicht immer gelungen.

Deshalb zitiere ich auch gerne Bertrand Russell:

» Jeder Zuwachs an Technik bedingt, wenn damit ein Zuwachs und nicht eine Schmälerung des menschlichen Glücks verbunden sein soll, einen entsprechenden Zuwachs an Weisheit. «

Ich nenne hier gerne den „Motorisierten individuellen Verkehr“ (MIV). Der den Planeten zerstört und pro Jahr 1,3 Millionen Todesopfer und die mehrfache Anzahl an verletzten bewirkt. Hier hat die Weisheit wohl gefehlt.

Aber wer hätte das vor 100 Jahren wissen sollen? Ich meine, dass technologischer Fortschritt immer verändert. Und jede Veränderung trägt Risiko in sich. Über das Risiko darf man aber die Chancen nicht vergessen. Besonders weil man in der Regel die wahren Nachteile erst a posterio erkennt. Insofern sollte man bei Hypes zwar (weise) vorsichtig aber nicht (dumm) ängstlich sein.

Der ganze Hype um Datenschutz und -sicherheit scheint mir ein gutes Beispiel für eine ganz besondere Form von Schwarmdummheit zu sein – ein Begriff den ich von Gunter Dueck übernehme.

Von der Philosophie zur Technik.

Die für Digitalisierung genutzte Hardware selber funktioniert immer noch nach denselben Prinzipien wie in den 70iger Jahre. Der von uns wahrgenommene Riesenfortschritt bei Rechner, Leitung und Speicher (die Dreifaltigkeit der IT) ist eine Folge des Moore’schen Gesetzes (formuliert im Jahre 1965). Diese Leistungsexplosion hat die Mustererkennung als Basis für viele Anwendungen fantastisch ermöglicht.

Das Prinzip dieser Art von KI ist ziemlich alt. Turing hat es schon vor vielen Jahrzehnten beschrieben – ich meine in den 40igern des letzten Jahrhunderts.

Damit erfolgten große Fortschritte bei Spracherkennung und -Ausgabe, die ja auch nur ein Auswerten und Umsetzen von Mustern sind. Das ist die zentrale Voraussetzung für die neue Art von Software, die selber lernt, wie man Sprachen übersetzt oder ein Auto steuert. Und die war halt früher einfach nicht von der Hardware zu bewältigen.

So hat Deepminds Alphazero-KI den besten asiatischen GO-Spieler und nach kurzem Lernen auch Goldfish (das beste Schachprogramm) vernichtend geschlagen. Aber halt, beim Go-Spiel sind die Chinesen aufgewacht und investieren jetzt in ungeahnten Dimensionen Geld und Menschen ins Thema KI. Und werden dann bald auch die Amis mit ihrem ollen Watson und vielleicht auch Googles Deepmind überholen.

🙂 Und wie die Chinesen aufgewacht sind, sind es auch die Bayern … Und die wollen es jetzt den Chinesen zeigen – was den Insider in Digitalisierung doch ein wenig schmunzeln lässt. Im Video wird zwar viel vom Weltraum gesprochen. Am Schluß dann von Robotern. Für beides ist IT und KI die Voraussetzung. Und die kriegt man nicht für ein paar Hundert Millionen. Da braucht es Milliarden.

Mit dem Laden des Videos akzeptieren Sie die Datenschutzerklärung von YouTube.

Mehr erfahren

Die Bayern haben dann natürlich nicht nur eine tolle Schau gemacht, sondern Taten folgen lassen. Und ein Ministerium für Digitalisierung gegründet und am 12. November 2018 eine junge Frau namens Judith Gerlach zur Staatsministerin für Digitales in Bayern gemacht.

Staatsministerin Judith Gerlach ist geboren am 3. November 1985 in Würzburg, verheiratet, zwei Kinder und römisch-katholisch.

Sie ist jung und wurde Ende 2018 erst 33 Jahre alt. Und dass sie zwei Kinder hat, qualifiziert sie auch. Immerhin habe ich vieles in Sachen Digitalisierung von meinen Kindern gelernt.

Ihr Lebenslauf zeigt, dass sie eine hochqualifizierte Juristin ist. Das macht mich nachdenklich, weil das mehr nach Datenschutz klingt als nach Hochtechnologie. Ich frage mich, ob sie sich vorstellen kann, was ein Betriebssystem denn so ist. Aber vielleicht wissen das ja ihre Berater?

Die Frau Staatsministerin hat dann auch auf der oben verlinkten Seite geschrieben:

„Ich sehe sehr große Chancen für den Standort Bayern: Wir haben uns bereits in vielen Bereichen an die Spitze digitaler Entwicklungen gesetzt und werden weiterhin alle Kräfte bündeln, um neue Technologien zu entwickeln und gesellschaftlich verantwortungsvoll mit ihnen umzugehen. Hierfür ist das neue Digitalministerium Motor, Koordinator und Denkfabrik.“

Judith Gerlach, MdL

Staatsministerin

Hätte sie eine Ahnung von Digitalisierung, dann hätte sie diesen Satz nie so geschrieben. Oder ihn vorher mal Leuten zu lesen gegeben, wie sie in Bayern im ZD.B sitzen. Die ziemlich viel Ahnung haben und auch eine Gründung des Freistaates sind.

Aber als Juristin hat sie ja eine gute Entschuldigung. Woher soll sie wissen, wo Bayern (oder Deutschland und Europa) digital im Weltvergleich technologisch stehen?

Vielleicht ist das ein neuer (alter) Hype, dass wir für die gesellschaftliche Gestaltung unseres technischen Fortschritts (nichts anderes ist die Digitalisierung) Jurist*innen einsetzen? Damit zumindest die AGBs (und der Datenschutz) stimmen?

Eine Antwort auf die internationale Positionierung der Wertschöpfung Europas gibt übrigens das vor kurzem ausgehandelte und in Kraft getretene Freihandelsabkommen EU-Japan (kurz EPA von englisch Economic Partnership Agreement, umgangssprachlich JEFTA genannt).

In einem Satz beschrieben wurde da ausgehandelt, dass Japan die Zölle für Agrar-Produkte aus Europa senkt, dafür senkt Deutschland die Einfuhrzölle für HighTec-Produkte aus Japan.

Der Trend scheint und ist klar: Bayern und Europa sind auf dem Weg zum Agrar-Land. Vielleicht noch zum Reiseland. Als HighTech-Exporteur sind wir abgehängt. Nicht nur in den internationalen Handelsabkommen, auch in der technischen Realistät.

Siehe unsere 5G-Probleme mit Huawei. Da erinnere ich mich an meinen ersten Job bei Siemens. Da war Kommunikation ein Hype. Und bei der damaligen Kommunikationstechnologie kam an Siemens weltweit keiner vorbei. Heute allerdings geht ohne (rot-)chinesische Technik da nichts mehr. Für die Freude von gestern zahlt heute keiner mehr.

Da klingt der obige Satz unserer Frau Staatsministerin wie Hohn:

Wir (Bayern) haben uns bereits in vielen Bereichen an die Spitze digitaler Entwicklungen gesetzt.

Das Gegenteil ist der Fall.

Was mich wundert, dass der mächtige VDA (Verband der Automobilindustrie e.V., Behrenstraße 35, 10117 Berlin) das Abkommen EPA/JEFTA nicht sabotiert hat. Denn immerhin könnten die Toyotas bei uns jetzt 10 % billiger werden. Wobei die Japaner kaum so dumm sein werden, die Ersparnisse beim Zoll an die deutschen Idiota-Fahrer in Deutschland weiter zu geben (ich bitte um Verzeihung für meinen primitiven Scherz).

Könnte es sein, dass der VDA andere Sorgen hat, weil mittlerweile auch bei unserer heiligen Kuh MIV (Motorisierter Individual Verkehr) andere uns technologisch weit voraus sind?

Deutschland profitiert beim Handels-Abkommen als drittgrößter Fleischexporteur der Welt. Besonders beim Schweine-Fleisch liegen wir weit vorne – und dies bald mit einem Tier-Wohl-Zertifikat vom Bundesministeriums für Ernährung- und Landwirtschaft (BMEL). Wenn das mal nicht zu einem neuen Schweine-Hype führt.

Ist das alles nicht ein Wahnsinn?

RMD

P.S.

Jetzt bin ich noch meine Definition zu KI/AI schuldig:

Ich meine, eine Alg-SW wird dann zur KI-Software,

wenn sie ihre funktionellen Mehrwert durch Lernen und Üben realisiert. Das heißt, viele Muster sammelt und analysiert, die mit Ergebnissen korreliert und bewertet werden können und so ein großes Erfahrungs-Wissen aufzubauen.

Das ist dann wahrscheinlich ein klein wenig ähnlich, wie das menschliche Gehirn funktioniert.

P.S.1

Hier geht es zu meinem ersten Jubiläumsartikel 50 Jahre in der IT.

2 Antworten

Interessant ist m.E. auch die Rezeption von „Neuheiten“.

„RISC“ sollte Prozessoren schneller machen. Sie zitieren das Trend-o-meter aus dem Jahre 1989 schon richtig.

Aber schon damals, als die Menschen, weil ohne Internet, wesentlich mehr zur Reflexion neigten, war die allgemeine Wahrnehmung so grottenfalsch, daß einem auch noch nach 30 Jahren das Herz stockt:

Es war die Vorgängerarchitektur CISC, die „den Prozessor schneller machte“. Ende der neunziger Jahre war der Speicherzugriff _DER_ Flaschenhals bei der Programmausführung. Also wendete CISC zwei geniale Tricks an:

1.

Kompaktifizierung des Assemblercodes, insbesondere Reduktion der möglichen internen Zielregister. So konnte man einen xchg register/register in zwei Bytes packen. Weil es nur vier mögliche Register gab, brauchte man für deren Spezifikation hat nur 2 Bits.

Je kompakter der Code, desto mehr Instruktionen pro Sekunde konnten aus dem Speicher gelesen werden.

2.

Mikroprogrammierung. Für typische Programmieraufgaben wie „Vergleiche eine Zeichenkette“ gab es Spezialbefehle, die etwa fünf Instruktionen zusammenfaßten, welche dann, typischerweise als Schleife, prozessorintern abgearbeitet wurden, ohne daß ein weiterer Zugriff im Instruktionsdatenstrom erforderlich gewesen wäre.

Es war also CISC (in Zusammenarbeit mit einer „prefetch queue“), welches „die Rechner schneller machte“, und zwar ganz ungemein.

RISC dagegen war schiere Simplifizierung. Die Codegröße explodierte. Es gab genau KEINEN GRUND zu applaudieren.

Außer vielleicht den Hardwareentwicklern, die unglaublich schnelle Speicherbausteine zur Serienreife brachten.

Aus diesem Grund hat IBM beispielsweise nie RISC-Prozessoren gebaut – auch wenn es jahrelang draufstand.

Der CISC / RISC – Hype ist ein Paradebeispiel für den erkenntnistheoretischen Ansatz des Till Eulenspiegel:

„Wenn der Kaiser nackt ist, ist der Kaiser nackt“.

Wah. Ende der achtziger und nicht der neunziger Jahre war der Speicherzugriff der Flaschenhals. Für den Fall, daß Chris Wood mitliest.